Token trong AI là gì là câu hỏi được nhiều người dùng đặt ra khi khám phá cách hoạt động của các mô hình trí tuệ nhân tạo như ChatGPT. Trong quá trình xử lý ngôn ngữ, token chính là đơn vị cơ bản giúp AI phân tách, hiểu và dự đoán nội dung một cách hiệu quả. Nhờ vào cơ chế này, các mô hình ngôn ngữ lớn (LLM) có thể tạo ra phản hồi tự nhiên, sát với ngữ cảnh và nhu cầu người dùng. Bài viết sau sẽ giúp bạn hiểu rõ hơn về vai trò của token trong thế giới AI hiện đại.

Token trong AI là gì?

Token trong AI là phần tử nhỏ nhất mà hệ thống xử lý ngôn ngữ có thể hiểu và làm việc với. Khi một đoạn văn bản được đưa vào mô hình AI, hệ thống sẽ chia nhỏ nó thành các token. Việc tách này giúp mô hình nhận diện và xử lý từng phần của văn bản dễ dàng hơn. Tùy vào cách thiết kế của từng hệ thống, một token có thể là một ký tự, một từ, hoặc thậm chí là một phần của từ.

Chẳng hạn, từ “playing” có thể được chia thành hai token là “play” và “ing”. Điều này giúp AI nắm bắt được cấu trúc từ ngữ và suy đoán ý nghĩa dựa trên từng thành phần nhỏ. Nhờ vậy, mô hình có thể hiểu đúng ngữ cảnh dù văn bản có dài hay phức tạp.

Ngoài ra, quá trình phân chia thành token còn giúp kiểm soát dung lượng dữ liệu đầu vào. Mỗi mô hình đều có giới hạn số token mà nó có thể xử lý trong một lần. Việc hiểu rõ khái niệm này sẽ giúp người dùng tận dụng hiệu quả hơn các công cụ như ChatGPT.

Tóm lại, token đóng vai trò là cầu nối giữa ngôn ngữ con người và khả năng xử lý của máy. Đây là bước đầu tiên và quan trọng trong mọi hoạt động liên quan đến trí tuệ nhân tạo ngôn ngữ.

Cách thức hoạt động của Token trong AI là gì?

Khi một đoạn văn bản được đưa vào hệ thống AI, bước đầu tiên là chuyển đổi văn bản đó thành các đơn vị nhỏ gọi là token. Quá trình này được gọi là tokenization. Tùy theo quy tắc của từng mô hình, một token có thể là một từ đầy đủ, một ký tự riêng lẻ hoặc một phần của từ. Ví dụ, từ “unbelievable” có thể được tách thành các token như “un”, “believ” và “able” để mô hình xử lý hiệu quả hơn.

Sau khi phân tách, mỗi token được gán một mã số tương ứng và được mã hóa thành vector số — dạng dữ liệu mà mô hình thần kinh có thể hiểu và xử lý. Đây là bước giúp văn bản tự nhiên được chuyển thành tín hiệu kỹ thuật số, tạo tiền đề cho các thao tác suy luận tiếp theo.

Trong quá trình tạo phản hồi, AI sẽ lần lượt đọc chuỗi token đầu vào để dự đoán token kế tiếp. Bằng cách này, mô hình sẽ dần xây dựng nên câu chữ, từ ý đầu tiên đến khi hình thành một đoạn văn hoàn chỉnh. Hoạt động này diễn ra theo chuỗi, từng bước một, giúp AI giữ mạch văn trôi chảy, phản hồi sát với ngữ cảnh. Đây chính là nguyên lý cốt lõi giúp ChatGPT và các mô hình ngôn ngữ lớn (LLM) hoạt động hiệu quả.

Các loại token phổ biến trong NLP

Khi tìm hiểu sâu hơn về token trong AI là gì, ta sẽ bắt gặp nhiều cách phân loại khác nhau tùy vào mục đích xử lý ngôn ngữ tự nhiên (NLP). Mỗi loại token đóng vai trò riêng trong việc giúp AI phân tích văn bản chính xác và linh hoạt hơn. Dưới đây là những loại token phổ biến nhất hiện nay:

Word Tokenization (tách từ): Đây là cách chia văn bản thành từng từ riêng biệt, thường dựa vào khoảng trắng hoặc dấu câu. Phương pháp này phù hợp với các ngôn ngữ như tiếng Việt hoặc tiếng Anh, nơi có ranh giới từ rõ ràng.

Sentence Tokenization (tách câu): Văn bản được chia theo từng câu bằng cách xác định dấu hiệu kết thúc như dấu chấm, chấm hỏi, hoặc chấm than. Kỹ thuật này giúp mô hình hiểu rõ ngữ cảnh ở cấp độ câu.

Character-based Tokenization (tách ký tự): Toàn bộ văn bản được chia thành từng ký tự riêng lẻ. Đây là cách tiếp cận hiệu quả trong các trường hợp cần phân tích kỹ từng chữ cái hoặc với ngôn ngữ không dùng khoảng trắng như tiếng Trung.

Subword-based Tokenization (tách phần từ): Từ được chia thành các đơn vị nhỏ hơn như tiền tố, hậu tố hoặc phần gốc. Nhờ vậy, mô hình có thể xử lý từ lạ tốt hơn. Phương pháp này được sử dụng rộng rãi trong các LLM hiện đại như BERT hoặc GPT.

Special Token (token đặc biệt): Là các token đại diện cho chức năng đặc thù như bắt đầu câu, kết thúc câu hoặc ký tự không xác định. Dù không mang nghĩa cụ thể, chúng giúp duy trì trật tự và ngữ cảnh trong văn bản.

Vai trò của token trong mô hình AI

Để hiểu sâu hơn về token trong AI là gì, ta cần nhìn vào vai trò thiết yếu của chúng trong quá trình hoạt động của các mô hình ngôn ngữ lớn (LLM) như ChatGPT.

Trước tiên, token giúp mô hình phân tích ngôn ngữ thành từng phần nhỏ, từ đó dễ dàng nắm bắt ngữ cảnh và xác định chính xác ý nghĩa của từng đoạn văn. Nhờ vậy, AI có thể hiểu được sự liên kết giữa các từ trong câu, giữa các câu trong đoạn, và từ đó đưa ra phản hồi phù hợp.

Tiếp theo, token chính là cầu nối giữa văn bản tự nhiên và dữ liệu số. Mỗi token được chuyển đổi thành một vector số, là dạng dữ liệu mà mạng nơ-ron có thể xử lý. Đây là bước quan trọng giúp AI thực hiện các phép tính phức tạp để tạo ra kết quả thông minh.

Ngoài ra, việc dự đoán token kế tiếp dựa trên chuỗi token trước đó chính là cách mà mô hình tạo ra câu trả lời. Cơ chế này giúp AI xây dựng nội dung một cách mạch lạc và logic.

Token còn đóng vai trò kiểm soát độ dài văn bản đầu vào. Mỗi mô hình có giới hạn số token tối đa mà nó có thể tiếp nhận. Điều này ảnh hưởng trực tiếp đến việc hiểu và phản hồi văn bản dài hay ngắn.

Cuối cùng, số lượng token cũng quyết định đến tốc độ xử lý và chi phí tính toán. Văn bản càng dài, số token càng nhiều, thì lượng tài nguyên cần dùng để xử lý cũng tăng theo. Do đó, việc tối ưu hoá số token giúp tiết kiệm đáng kể chi phí vận hành và thời gian.

Cách tính số lượng token trong văn bản

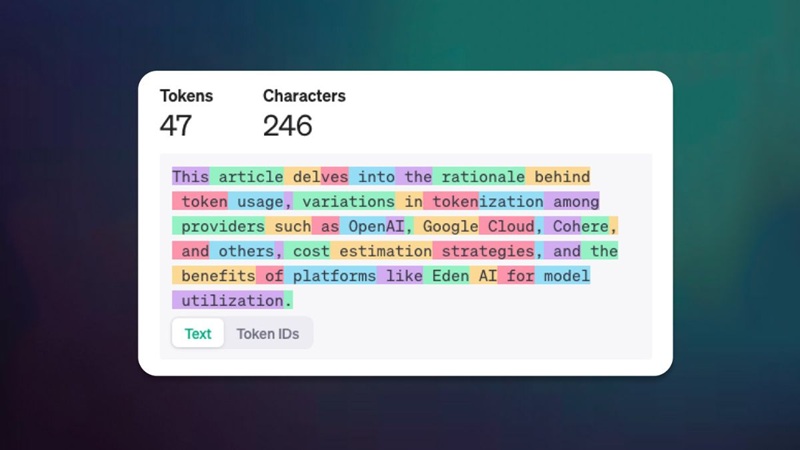

Khi tìm hiểu sâu hơn về token trong AI là gì, một khía cạnh không thể bỏ qua chính là cách xác định số lượng token trong một đoạn văn bản. Đây là yếu tố quan trọng trong việc kiểm soát dung lượng đầu vào và ước tính chi phí xử lý khi sử dụng các mô hình ngôn ngữ như ChatGPT.

Quá trình tính số token bắt đầu bằng việc văn bản được đưa qua một bộ mã hóa đặc biệt. Bộ mã hóa này sẽ chia văn bản thành các đơn vị nhỏ — gọi là token — theo quy tắc riêng. Một token có thể là một từ đầy đủ, một phần của từ, hoặc thậm chí là một dấu câu. Ví dụ, từ “điện thoại” có thể được mã hóa thành một token duy nhất, nhưng cũng có thể tách thành hai phần “điện” và “thoại” tùy theo hệ thống đang sử dụng.

Sau khi quá trình tokenization hoàn tất, số lượng token trong văn bản được tính bằng cách cộng tất cả các token đã sinh ra. Kết quả này sẽ ảnh hưởng trực tiếp đến hai yếu tố quan trọng: giới hạn độ dài văn bản đầu vào và chi phí xử lý. Các mô hình AI thường có ngưỡng giới hạn token tối đa, vì vậy nếu văn bản vượt quá con số này, phần cuối văn bản có thể bị cắt bớt hoặc phải rút gọn nội dung.

Việc hiểu rõ cách tính token giúp người dùng tối ưu hóa nội dung khi tương tác với các hệ thống AI, đồng thời quản lý hiệu quả chi phí và hiệu suất xử lý.

Cách tối ưu token hiệu quả

Hiểu rõ token trong AI là gì không chỉ giúp người dùng tận dụng tốt các mô hình ngôn ngữ, mà còn mở ra cách để tối ưu hóa chi phí và hiệu suất xử lý. Dưới đây là những chiến lược đơn giản, hiệu quả để giảm số lượng token mà vẫn giữ nguyên chất lượng đầu vào và đầu ra.

Tránh gửi đầu vào quá dài:

Thay vì đưa toàn bộ đoạn văn hoặc tài liệu vào mô hình, hãy xác định rõ đâu là phần thông tin thực sự cần thiết. Việc tinh gọn nội dung giúp mô hình tập trung vào nhiệm vụ chính, phản hồi nhanh hơn và tiết kiệm đáng kể tài nguyên.

Đặt giới hạn độ dài cho câu trả lời:

Trong phần hướng dẫn cho mô hình, bạn có thể yêu cầu phản hồi theo khuôn khổ nhất định như “tóm tắt trong 3 câu” hoặc “viết trong 200 từ”. Điều này không chỉ giúp kiểm soát số token đầu ra mà còn mang lại câu trả lời đúng trọng tâm.

Thiết lập tham số max_tokens:

Nhiều hệ thống AI hiện nay cho phép cài đặt giới hạn token đầu ra. Việc quy định số token tối đa là cách hữu hiệu để tránh phản hồi lan man hoặc vượt quá phạm vi mong muốn.

Tái xử lý hoặc rút gọn câu lặp:

Trước khi gửi nội dung vào mô hình, hãy rà soát và loại bỏ những phần thừa, các cụm từ trùng lặp, hoặc các câu có thể gộp lại. Việc làm này giúp giảm tải số token một cách đáng kể mà không ảnh hưởng đến ý nghĩa chung.

Một từ có thể là nhiều token trong AI không?

Có. Trong các mô hình AI hiện đại như ChatGPT, một từ hoàn toàn có thể được tách thành nhiều token. Điều này thường xảy ra khi từ đó quá dài, hiếm gặp, viết tắt phức tạp, hoặc chứa ký tự đặc biệt không phổ biến trong từ điển mã hóa của mô hình.

Ví dụ, từ tiếng Anh đơn giản như “apple” thường sẽ được mã hóa thành một token duy nhất. Nhưng với một từ phức tạp như “antidisestablishmentarianism”, mô hình có thể tách thành nhiều phần nhỏ hơn như “anti”, “dis”, “establish”, “ment”, “arian”, “ism”. Đây là cách mà hệ thống tiết kiệm không gian từ vựng mà vẫn có thể xử lý linh hoạt các từ lạ.

Tạm kết

Token trong AI là chìa khóa giúp các mô hình như ChatGPT hiểu, phân tích và tạo ra ngôn ngữ một cách thông minh. Dù chỉ là đơn vị nhỏ nhất trong văn bản, token lại giữ vai trò nền tảng trong mọi hoạt động xử lý ngôn ngữ. Nắm rõ khái niệm Token trong AI là gì không chỉ giúp bạn tận dụng AI hiệu quả hơn, mà còn tối ưu chi phí và nâng cao chất lượng tương tác với các mô hình ngôn ngữ hiện đại.

Xem thêm:

OPPO AI Mind Space là gì? Tất tần tật các tính năng AI mới

Luma AI là gì? Các tính năng nổi bật và cách tạo tài khoản sử dụng